大数据文摘出品

当地时间6月12日,ICML 2019于美国长滩市公布了本届大会最佳论文结果。

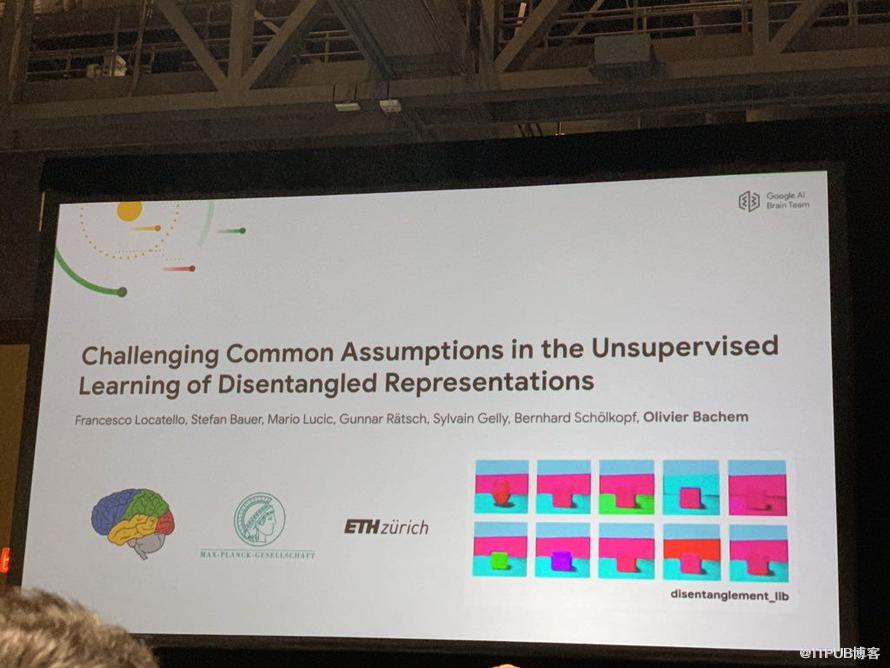

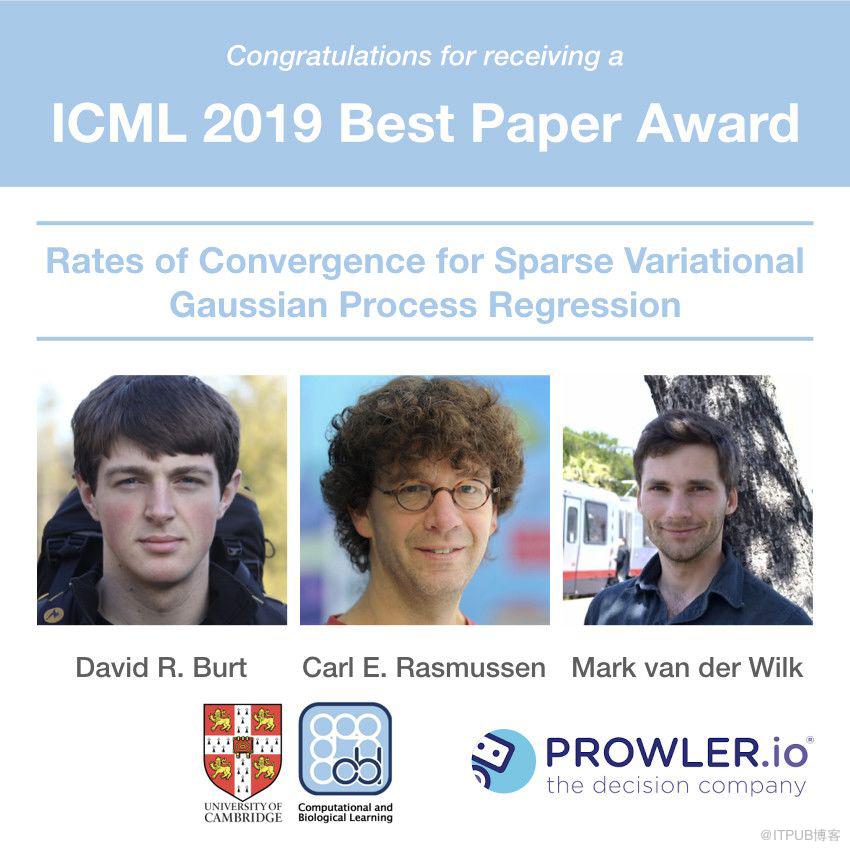

谷歌大脑、MaxPlanck和苏黎世联邦理工学院合作的《挑战无监督分离式表征的常见假设》,以及剑桥大学的一篇《稀疏变分高斯过程回归的收敛速率》作为最佳论文摘得桂冠。另外,还有七篇论文获得提名奖。

今年的论文录取竞争异常激烈,ICML 2019共提交了3424篇论文,其中录取774篇,论文录取率为22.6%。录取率较去年ICML 2018的25%有所降低。

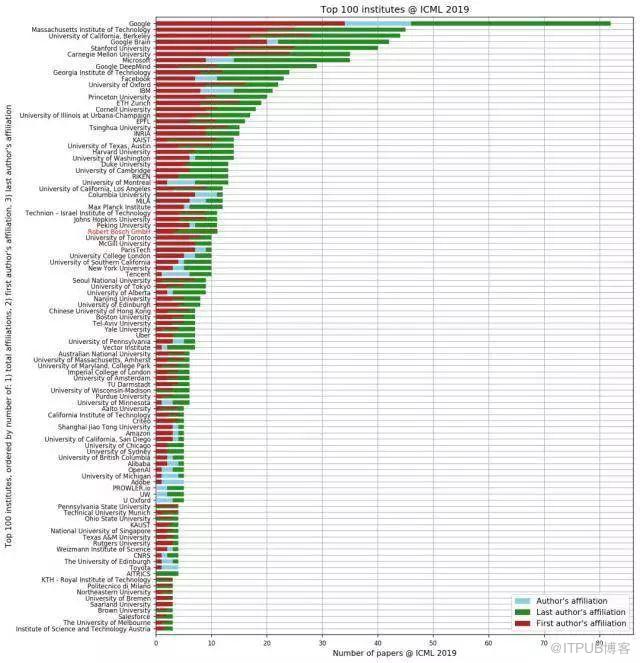

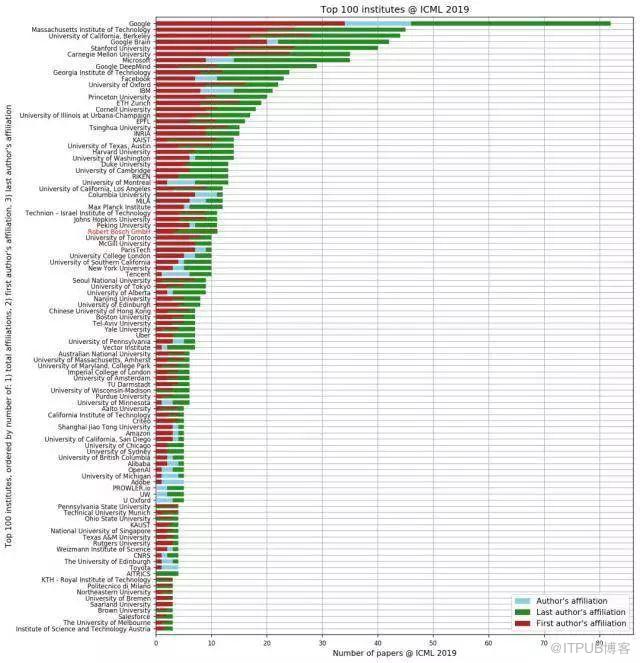

ICML 2019接收论文贡献数排名前50的机构(学界机构和业界机构)

论文录取结果地址:

https://icml.cc/Conferences/2019/AcceptedPapersInitialfbclid=IwAR0zqRJfPz2UP7dCbZ8Jcy7MrsedhasX13ueqkKl934EsksuSj3J2QrrRAQ

第一篇最佳论文的作者来自苏黎世联邦理工学院(ETH Zurich)、MaxPlanck 智能系统研究所及谷歌大脑。

深度学习的一个重要挑战是用无监督学习的方式理解现有数据。目前主要提出的方法是一个利用分离式表征 (disentangled representation) 的模型,它可以捕捉到各种相互独立的特征,如果其中一个特征改变了,其他特征不会受到影响。

而该团队测试了12,000个模型之后,对现有无监督分离式表征学习研究发出了严重的质疑。

首先,并没有发现任何经验证据,显示无监督方法可以学到可靠的分离式表征,因为随机种子和超参数似乎比模型的选择更重要。也就是说,就算训练了大量的模型,一部分可以得出分离式表征,也很难在不看标签的情况下就把这些表征找出来。

其次,在参加评估的模型和数据集上,分离式表征并不一定对后续任务有帮助,结果表明用了分离式表征也不等于说AI就可以用更少的标注来学习。

最后,论文给研究者提出建议,因为根据检测结果,不带归纳偏置 (Inductive Biases) 的无监督学习的分离式表征是不可能实现的,未来的研究应该清楚地描述出归纳偏置,以及隐式和显式的监督方式。

论文地址:

http://proceedings.mlr.press/v97/locatello19a/locatello19a.pdf

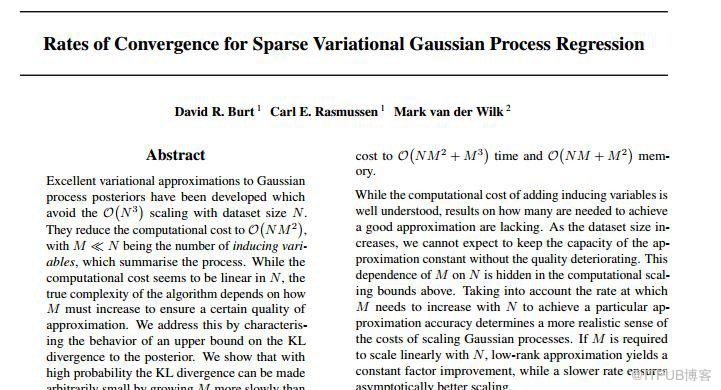

这篇最佳论文是来自英国剑桥大学和机器学习平台Prowler.io的研究。论文名称为《稀疏高斯过程回归变分的收敛速度》(Rates of Convergence for Sparse Variational Gaussian Process Regression)。此论文的工作是证明了稀疏GP回归变分近似到后验变分近似的KL发散的界限,该界限仅依赖于先验核的协方差算子的特征值的衰减。

论文地址:

https://arxiv.org/pdf/1903.03571.pdf

这篇论文的第一作者是来自剑桥大学信息工程系的博士研究生David Burt,其主要研究领域是贝叶斯非参数和近似推理。另一位作者是Mark van der Wilk,剑桥大学机器学习专业的在读博士研究生,主要的研究领域是贝叶斯推理、强化学习、高斯过程模型等。

除了2篇最佳论文外,还有7篇论文获得最佳论文提名,分别为:

1、Analogies Explained: Towards Understanding Word Embeddings(爱丁堡大学)

论文地址:

https://arxiv.org/abs/1901.09813

2、SATNet: Bridging deep learning and logical reasoning using a differentiable satisfiability solver(CMU、南加州大学等)

论文地址:

https://arxiv.org/abs/1905.12149

3、A Tail-Index Analysis of Stochastic Gradient Noise in Deep Neural Networks(巴黎萨克雷大学等)

论文地址:

https://arxiv.org/abs/1901.06053

4、Towards A Unified Analysis of Random Fourier Features(牛津大学、伦敦过国王学院)

论文地址:

https://arxiv.org/abs/1806.09178

5、Amortized Monte Carlo Integration(牛津大学等)

论文地址:

http://www.gatsby.ucl.ac.uk/~balaji/udl-camera-ready/UDL-12.pdf

6、Social Influence as Intrinsic Motivation for Multi-Agent Deep Reinforcement Learning(MIT、DeepMind、普林斯顿)

论文地址:

https://arxiv.org/abs/1810.08647

7、Stochastic Beams and Where to Find Them: The Gumbel-Top-k Trick for Sampling Sequences Without Replacement(荷兰阿姆斯特丹大学等)

论文地址:

https://arxiv.org/abs/1903.06059

首先来回顾一下2018年ICML最佳论文;

第一篇是:

Obfuscated Gradients Give a False Sense of Security: Circumventing Defenses to Adversarial Examples

Anish Athalye (MIT), Nicholas Carlini (UCB), David Wagner(UCB)

论文地址:

https://arxiv.org/pdf/1802.00420.pdf

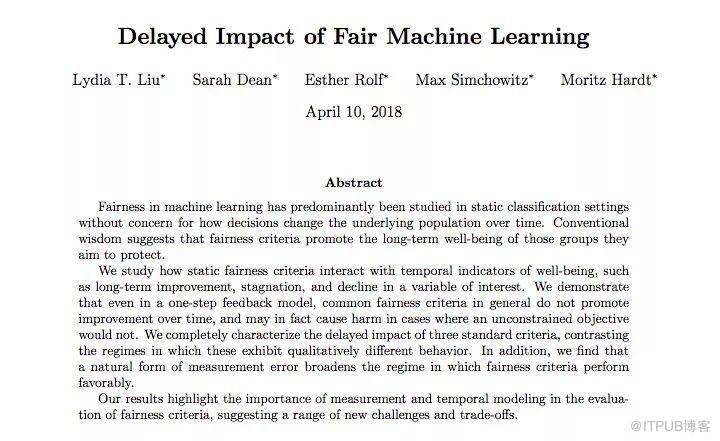

第二篇是:

Delayed Impact of Fair Machine Learning

Lydia Liu, Sarah Dean, Esther Rolf, Max Simchowitz, Moritz Hardt (全员UCB)

论文地址:

https://arxiv.org/pdf/1803.04383

从两年的最佳论文评选结果来看,ICML似乎对于质疑性的研究特别中意。

2018年第一篇最佳论文质疑了当时普遍使用的构建防御对抗样本,增加神经网络鲁棒性的方法——它们都可以被更强大的优化攻击击败。

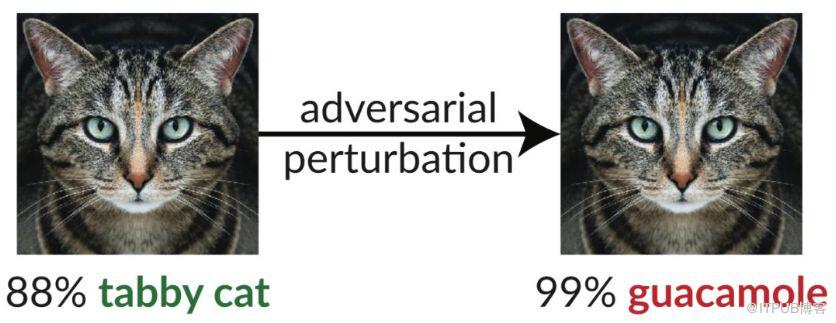

加入了肉眼看不见的扰动,这张猫的图片就可以欺骗 InceptionV3 分类器,使其分类为「鳄梨酱」

并且它们使用ICLR 2018接收论文中的防御对抗样本论文作为研究对象,成功攻破了8 篇有关防御对抗样本的研究中的7篇。

而第二篇同样也是质疑了机器学习在采用历史数据集时,会产生“偏见”的问题,从而影响到模型对现在的分析或者对未来的预测是否是中立的,会不会对弱势群体存在忽略。

而今年的则貌似更“过分”,来自谷歌的最佳论文则质疑了几乎所有同行在无监督分离式表征学习研究方向的努力。论文提出,在数据集和模型没有归纳偏置 (Inductive Biases) 的情况下,试图通过无监督的方法学习到可靠分离式表征,从而来让机器学习系统去应对没有遇到过的场景,这是无法实现的。

今年,国内企业在 ICML 会议上的成果则显得较为低调,据目前公开资料统计,仅有少量的研究成果,其中,腾讯、阿里巴巴等科技公司依然领跑。其中腾讯的数量为10篇,阿里被收录5篇,百度有一篇。

论文数量排名前五的公司分别是谷歌、谷歌大脑、微软、DeepMind、Facebook,论文数量分别为:82、42、35、29、23。

ICML 2019接收论文贡献数排名前50的业界机构

从高校的角度看,中国有四所大学进去TOP50,其中清华大学15篇,北京大学11篇,而南京大学和香港中文大学分别是8篇和7篇。值得一提的是,排名第一的麻省理工论文数量为47篇。

将业界和学界分开来看,纯学术研究论文有452篇(58.4%);仅有60篇论文纯粹是由业界研究机构完成的;既包含业界也包含学界作者的论文有262篇(33.9%)。总结学界和业界对所有论文的相对贡献可以得到: